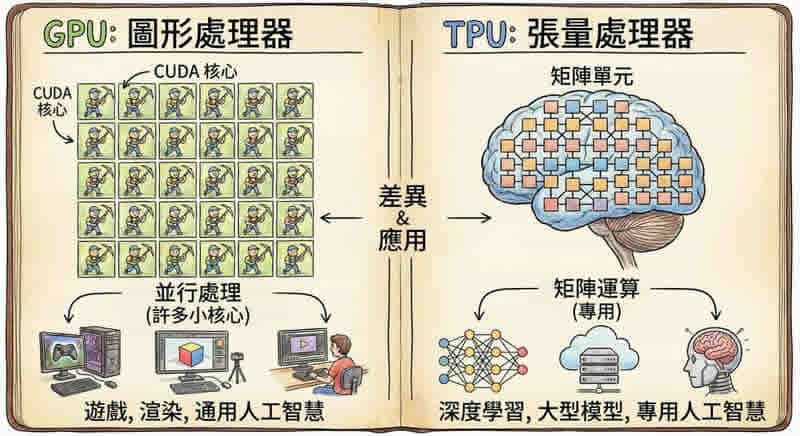

當我們談到人工智慧運算,GPU 和 TPU 是兩個不可避免的關鍵字。這兩種處理器各有千秋,選擇哪一個往往決定了你的 AI 專案是成功還是失敗。今天,我們就來深入探討這兩種技術的差異,以及它們各自適合的應用場景。

從歷史說起:GPU 與 TPU 的誕生背景

GPU:從遊戲到 AI 的華麗轉身

GPU(圖形處理單元)最早是為了遊戲和 3D 圖形渲染而設計的。2000 年代初期,史丹佛大學的研究人員發現,GPU 強大的平行運算能力不只能用於繪製遊戲畫面,還能加速科學運算。這個發現促使 NVIDIA 在 2006 年推出了 CUDA(Compute Unified Device Architecture)平台,正式將 GPU 從圖形處理器轉型為通用平行運算處理器。

從那時起,GPU 就成為了 AI 和機器學習領域的主力硬體。它們包含數千個小型運算核心,可以同時處理大量運算任務,這正是訓練神經網路所需要的能力。

TPU:Google 為 AI 量身打造的專用晶片

TPU(張量處理單元)則是 Google 在 2013 年開始研發、2016 年正式發表的專用 AI 加速器。當時 Google 發現,如果每個用戶每天對 Google 說三分鐘的話,他們就需要將資料中心的電腦數量增加一倍。為了解決這個問題,Google 決定開發專門針對機器學習運算的 ASIC(應用專用積體電路)。

令人驚訝的是,Google 團隊只用了 15 個月就完成了從設計到量產的過程。早在 2015 年,TPU 就已經在 Google 的資料中心中運作,只是當時外界還不知道它的存在。

🔔 不錯過任何精彩! 立即訂閱我們的 LINE 官方帳號

每次發佈新文章時,您將會第一時間收到本站文章連結通知,輕鬆掌握最新資訊!

核心架構:設計理念的根本差異

快速比較:GPU vs TPU 核心規格

架構類型

CUDA 核心 + Tensor Core

脈動陣列 (Systolic Array)

核心數量

數千至上萬個

(如 RTX 4090: 16,384)

專用矩陣運算單元

(如 TPU v1: 65,536)

運算精度

FP32, FP16, INT8 等多種

bfloat16, INT8 優化

記憶體存取

頻繁存取 VRAM

資料在運算單元間直接傳遞

靈活性

高 - 可執行各種運算

低 - 專為矩陣運算優化

表格比較 GPU(圖形處理器)與 TPU(張量處理器)七大關鍵特性,適用於 AI 與高效能運算場景。

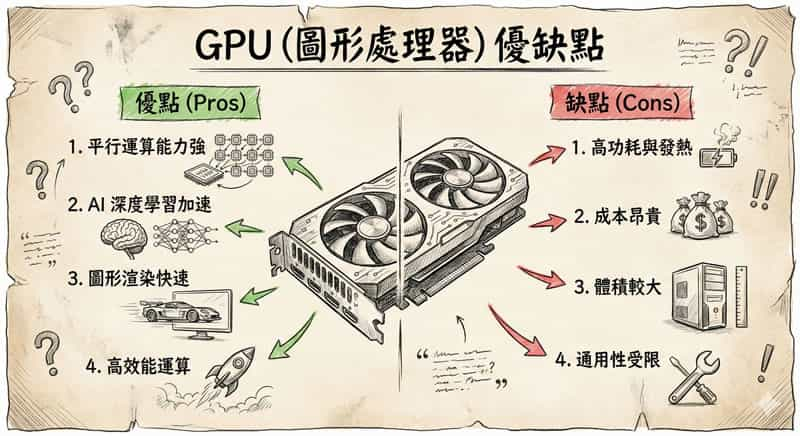

GPU:通用平行處理的靈活巨人

GPU 的架構是為了處理各種不同的任務而設計的。一個現代 GPU 包含數千個 CUDA 核心(NVIDIA 的叫法,AMD 則稱為串流處理器),這些核心可以同時執行大量運算。例如,RTX 4090 就擁有超過 16,000 個 CUDA 核心。

此外,新世代的 GPU 還加入了 Tensor Core,這是專門為深度學習設計的硬體加速單元。Tensor Core 可以快速執行混合精度矩陣運算,對訓練大型神經網路特別有幫助。

GPU 的強項在於它的「通用性」它可以執行各種不同的運算任務,從圖形渲染、科學模擬到 AI 訓練都能勝任。但這種靈活性也是有代價的:GPU 需要額外的硬體來處理複雜的指令、記憶體管理和執行緒調度,這些都會消耗能源和晶片面積。

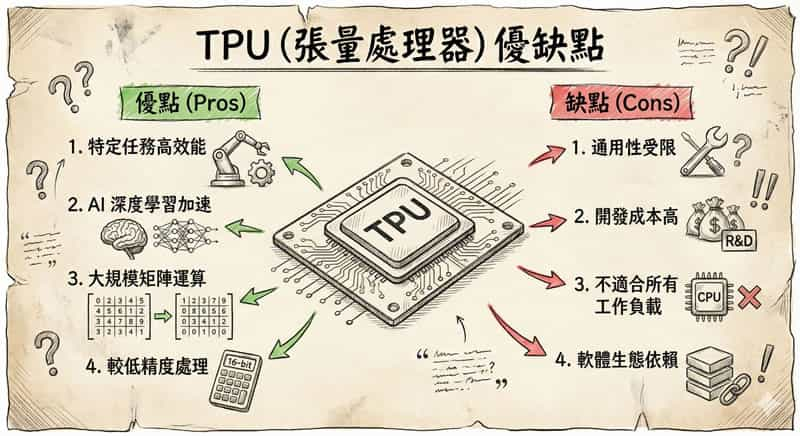

TPU:專為神經網路優化的矩陣處理器

TPU 採用了完全不同的設計思路。它使用一種稱為「脈動陣列」(Systolic Array)的架構,這是一個專門為矩陣運算設計的硬體結構。

想像一下,在傳統的 CPU 或 GPU 中,每次運算都需要從記憶體讀取資料、進行計算、再把結果寫回記憶體。這個過程就像在超市排隊結帳,每次都要來回走動。而 TPU 的脈動陣列就像一條流水線,資料在運算單元之間直接傳遞,不需要頻繁存取記憶體。

第一代 TPU 包含 65,536 個 8 位元乘法累加單元,以 700 MHz 的頻率運作。這意味著它每秒可以執行 92 兆次運算(92 Teraops)。更重要的是,在執行這些大規模矩陣運算時,所有中間結果都在 65,536 個運算單元之間直接傳遞,完全不需要存取記憶體,大幅降低了能耗並提升了效能。

TPU 還針對機器學習做了其他優化,例如使用 Google 開發的 bfloat16 數值格式,在保持運算精度的同時減少記憶體頻寬需求。

效能與效率:誰更勝一籌?

運算效能與能耗比較

項目

GPU (NVIDIA A100)

TPU v4

TPU v6 (Trillium) 🆕

運算效能

(基準:A100 = 1.0x)

1.0x

▲ 1.05–1.87x

(依模型/框架而異)

▲ 2.0x

(vs TPU v4)

每瓦效能

(效能/功耗)

1.0x

▲ 1.7x

▲ 2.8x

(1.7 × 1.67)

功耗

300–700W

(典型 AI 負載 ≈ 400W)

175–250W

(平均 200W)

更低

(具體未公開,預估 ≤150W)

年電費

(24/7 運作,$0.08–$0.20/kWh)

$280–$700

(以 400W 計)

$140–$350

(以 200W 計)

≈$105–$260

(預估 150W)

冷卻需求

高

需複雜風冷/液冷系統

中等

整合液冷支援

中等

優化熱密度設計

註:電費計算基準:$ \text{年耗電量} = \frac{\text{瓦數} \times 24 \times 365}{1000} \, (\text{kWh}) $,電價區間 $0.08–\$0.20/\text{kWh}$(美國平均)。TPU v6 數據基於 Google I/O 2024 公開資訊推估。

運算效能比較

在純粹的運算能力上,GPU 和 TPU 各有所長。根據 Google 的數據,TPU v4 在某些機器學習任務上比 NVIDIA A100 快 5-87%,而最新的 TPU v6 據稱比 TPU v4 快了近 2 倍。

但真正的差異在於「每瓦效能」——也就是每消耗一單位電力能完成多少運算。TPU v4 的每瓦效能比 A100 高出 1.7 倍,比上一代 TPU v3 高出 2.7 倍。最新的 Trillium(TPU 第六代)更是比前一代節能 67%。

這意味著什麼?當你在訓練大型語言模型時,使用 TPU 可以減少 20-30% 的整體成本,包括電力、冷卻和維護費用。在大規模部署的情境下,這個差異會被放大。

能源消耗對比

讓我們看看實際的能耗數字:

- 高階 GPU:通常消耗 300-700W,未來的型號甚至可能達到 800-1000W

- TPU v4:每個晶片僅消耗 175-250W,平均約 200W

以美國的電價計算(每度電 $0.08-$0.20),一個 400W 的 GPU 持續運作一年的電費約 $280-$700,而 200W 的 TPU v4 只需要大約一半的費用。

更重要的是,較低的能耗也意味著較少的散熱需求。高效能 GPU 產生大量熱能,需要先進的散熱系統(空氣冷卻、液體冷卻或混合系統)。TPU 雖然也需要冷卻,但通常整合了液冷系統,整體的冷卻成本和能耗都更低。

適用場景:選擇的藝術

應用場景快速對照表

大型語言模型訓練

超大規模矩陣運算、能源效率高、TPU Pod 可擴展至數千晶片

電腦視覺(即時)

低延遲、支援 CUDA Graph / TensorRT、可彈性處理 detection / segmentation / tracking 多種模型

推薦系統

TPU v4/v6 內建 SparseCores,大幅加速 embedding lookup 與稀疏矩陣乘法

研究與實驗

高靈活性:支援 PyTorch / JAX / TensorFlow,即時 debug 與 custom kernel 開發

高吞吐量推論

TPU Serving 可達 百萬級 QPS,批次處理效率極高,適合雲端 API 服務

3D 渲染

TPU 不支援 OpenGL/Vulkan;GPU 具備 RT Core / Tensor Core 混合加速

科學模擬

通用運算能力:支援 double precision、MPI 整合、既有 CUDA/HPC 工具鏈

醫療影像分析

小規模:GPU(彈性高);大規模部署:TPU(成本/效能比優);依資料量與框架(MONAI vs TensorFlow)選擇

跨雲端部署

AWS / Azure / GCP 均提供 GPU(A10G, L4, A100);TPU 僅限 GCP,移植成本較高

圖示說明:

🟢 TPU(Google Cloud 專用)、🔵 GPU(跨平台通用)、🟡 兩者皆可(依情境評估)|

⭐ 數量反映「相對適配強度」,非絕對效能值。

GPU 的優勢領域

GPU 最大的優勢在於它的「萬用性」和「生態系統成熟度」。以下是 GPU 特別擅長的場景:

- 多樣化的 AI 工作負載:如果你的專案需要處理各種不同類型的機器學習任務,GPU 是更好的選擇。它支援各種框架(TensorFlow、PyTorch、Caffe 等),可以輕鬆切換不同的模型架構。

- 研究與實驗:在學術研究或早期開發階段,你可能需要快速迭代和實驗不同的模型。GPU 的靈活性讓你可以自由嘗試,不用擔心硬體限制。

- 電腦視覺與即時推論:對於需要即時處理的應用(如自動駕駛、即時影像辨識),GPU 的低延遲特性更為關鍵。

- 跨雲端平台部署:GPU(尤其是 NVIDIA 的產品)在所有主要雲端平台都有支援AWS、Google Cloud、Azure 都提供 GPU 服務。如果你的資料分散在不同的雲端平台,使用 GPU 可以避免高昂的資料傳輸成本。

- 圖形渲染與科學運算:如果你的工作不只是 AI,還包括 3D 渲染、物理模擬等,GPU 是唯一的選擇。

TPU 的適用情境

TPU 雖然專用性強,但在特定場景下的效能無人能及:

- 大規模語言模型訓練:訓練像 GPT、PaLM 這類擁有數千億參數的模型時,TPU 的優勢最為明顯。Google 使用 6,144 個 TPU v4 晶片訓練 PaLM 模型,展現了 TPU 在超大規模訓練上的能力。

- 推薦系統:TPU 內建的 SparseCores 專門加速基於嵌入向量的模型,這對推薦系統特別有用。線上平台可以使用 TPU 處理數十億次的用戶互動。

- 高吞吐量推論:當你需要每秒處理數百萬次推論請求時(例如 Google 搜尋、YouTube 推薦),TPU 的高吞吐量和低延遲特性非常合適。

- 醫療與科學影像:處理衛星影像、醫學影像這類需要處理大量高解析度圖片的任務,TPU 的高效能矩陣運算能力可以大幅縮短訓練時間。

- TensorFlow/JAX 生態系統:如果你的專案主要使用 TensorFlow 或 JAX,並且部署在 Google Cloud 上,TPU 可以提供最佳化的體驗。

成本考量:不只是硬體價格

總擁有成本 (TCO) 比較

初始成本

較高

較低 ▼

GPU:需預購伺服器(A100 單卡 ≈ $10,000–$15,000)

TPU:僅雲端提供,按需計費(v4 Pod: $2.36/hr)

電力成本

基準(1.0x)

節省 20–30% ▼

同等算力下,TPU 因高每瓦效能,年省電費數千美元(見前表)

冷卻成本

較高

較低 ▼

GPU:風冷不足時需液冷方案(每機櫃 $5k–$20k)

TPU:Google 數據中心已整合液冷,用戶無需負擔

維護成本

中等

較低 ▼

GPU:需系統管理員監控溫度、驅動、故障

TPU:完全託管於 GCP,Google 負責硬體維運

每美元效能

基準(1.0x)

**1.4–4 倍**

TPU 在 LLM 訓練、推薦系統等場景具顯著優勢;

(Google Research: PaLM-540B 訓練成本節省 38%)

開發時間

中等

可能更快

🌟 真實案例

某醫療新創:MRI 分析模型訓練從 6 個月 → 6 週

(改用 TPU v4 + JAX,自動分片 + XLA 編譯加速)

註:

• 初始成本以「自建 GPU vs 雲端 TPU」為基準;若採雲端 GPU(如 AWS p4d),初始成本差距縮小,但每小時費用仍略高於 TPU。

• 「每美元效能」為特定工作負載(如 BERT-Large 訓練)平均值,非通用指標。

選擇 GPU 或 TPU 不能只看硬體本身的價格,還要考慮整體擁有成本(Total Cost of Ownership, TCO):

初始成本

- GPU:從入門級的 RTX 3060(適合小規模實驗)到高階的 H100,價格範圍很廣

- TPU:目前主要透過 Google Cloud 提供,採用按使用量計費的模式

營運成本

TPU 在大規模部署時通常比 GPU 更省錢:

- 電力成本降低 20-30%

- 冷卻成本更低

- 維護需求較少

- 在特定應用上,每美元效能可達 GPU 的 1.4-4 倍

時間成本

更快的訓練速度意味著更快的產品上線時間。有醫療新創公司報告,使用 TPU 基礎設施將 AI 產品開發時間從六個月縮短到六週。

實際案例:誰在用什麼?

Google 的 AI 服務

Google 自家的服務全面採用 TPU:

- 搜尋引擎:使用 TPU 處理自然語言理解和排序

- YouTube:推薦系統和內容審核

- Google Photos:影像辨識和分類

- Gemini:大型語言模型的訓練和推論/li>

其他企業的選擇

許多企業則選擇 GPU,原因包括:

- 需要跨多個雲端平台部署(AWS、Azure、GCP)

- 使用 PyTorch 等 TPU 支援較弱的框架

- 需要處理混合工作負載(不只是深度學習)

- 已有的團隊對 CUDA 生態系統更熟悉

競爭還在繼續

AI 硬體的競爭遠未結束。NVIDIA 持續推出新一代產品,預計的 H200 和 Blackwell B100 都承諾帶來 2.5-4 倍的效能提升。

Google 方面,最新的 Ironwood(第七代 TPU)專為推論優化,號稱比第一代 TPU 節能 30 倍,並能擴展到 9,216 個晶片,提供超過 42.5 Exaflops 的運算能力,這比世界上最大的超級電腦還要強大 24 倍。

此外,其他科技巨頭也在開發自己的 AI 晶片:

- AWS 的 Inferentia 和 Trainium

- Microsoft 的 Maia 晶片

- Apple、Tesla、Meta 也都在投資客製化晶片

這場競賽不只是關於速度,更關於軟硬體的深度整合、雲端基礎設施的優化,以及從模型訓練到即時服務的端到端優化。

結語

GPU 和 TPU 不是誰取代誰的關係,而是各有專精的互補技術。GPU 像是多功能的瑞士刀,適合各種場景;TPU 則像是專業的手術刀,在特定任務上無人能及。

對大多數開發者和研究者來說,GPU 仍是更容易上手和更靈活的選擇。但如果你正在處理超大規模的深度學習任務,尤其是在 Google Cloud 生態系統中,TPU 能帶來顯著的效能和成本優勢。

最終,最好的選擇永遠是根據你的具體需求、預算、技術堆疊和團隊能力來決定。在這個 AI 快速發展的時代,了解這些工具的特性,才能做出最適合自己的選擇。